Meta vient de lever le voile sur la nouvelle version de son accélérateur d’inférence d’intelligence artificielle développé en interne, le Meta Training and Inference Accelerator (MTIA). Succédant à la première génération présentée l’an dernier, cette puce de nouvelle génération est spécifiquement conçue et optimisée pour les charges de travail d’IA uniques à Meta, en particulier ses modèles de recommandation qui améliorent diverses expériences produit.

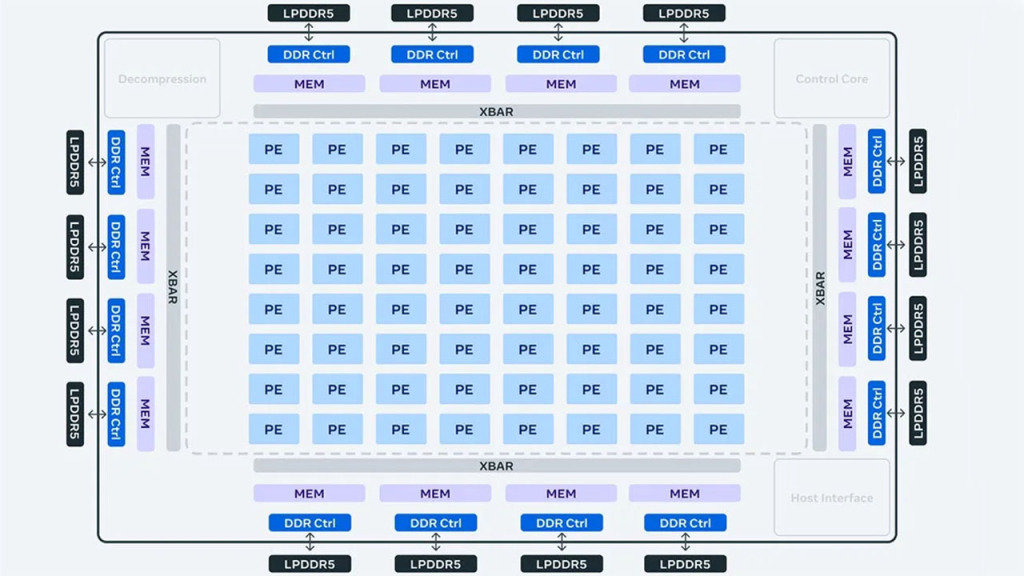

L’architecture de MTIA v2 se concentre sur l’équilibre optimal entre puissance de calcul, bande passante mémoire et capacité mémoire pour servir efficacement ces modèles. La puce comprend une grille 8×8 d’éléments de traitement offrant des gains significatifs aussi bien en calcul dense (3,5x par rapport à v1) qu’en calcul éparse (7x), grâce à des améliorations de pipeline et une augmentation des mémoires et de la bande passante à tous les niveaux.

Un réseau sur puce amélioré double aussi la bande passante et permet une coordination à faible latence entre les éléments de traitement. Ces nouvelles fonctions sont essentielles à la feuille de route long terme de Meta pour adapter MTIA à des charges d’IA plus exigeantes.

MTIA V2 & PyTorch 2.0

Sur le plan logiciel, la pile MTIA est conçue pour une intégration complète avec PyTorch 2.0 dont Meta est à l’origine. Un nouveau backend de compilateur appelé Triton-MTIA a été développé, tirant parti du langage open source Triton pour générer du code très performant et spécifique au matériel MTIA. Il offre une couverture étendue des opérateurs PyTorch.

Les premiers résultats sont prometteurs, montrant un gain de performance de 3x par rapport à MTIA v1 sur quatre modèles clés. Au niveau système, avec 2x plus d’accélérateurs et des CPU puissants, le débit de traitement des modèles est multiplié par 6, pour un rendement performance/watt 1,5x supérieur à la génération précédente.

MTIA v2 est d’ores et déjà déployé en production dans les data centers de Meta et sert des modèles. Cette solution sur mesure se révèle très complémentaire des GPU du commerce pour obtenir un mix optimal de performance et d’efficacité sur les charges d’IA spécifiques à Meta.

Au-delà des puces de calcul, Meta investit sur le long terme dans tout le spectre des technologies silicium pour l’IA afin de répondre à ses besoins uniques : mémoire, réseau, systèmes de nouvelle génération… Plusieurs programmes sont en cours, y compris un élargissement de MTIA aux charges émergentes d’IA générative.

Accédez à toute l’actualité IA sur Pause Hardware.